CVPR2017 備忘録 — Action Recognitionを中心に — Memo on CVPR17

2017.07.30

2017.07.30

CVPR17@HAWAIIに参加しました。メインコンファレンス4日間、前後に1日ずつワークショップとチュートリアルの全6日間のリッチな日程です。

数的な概要は以下の通りです。

以下は、Action Recognition関連の発表についてのヒヤリングやポスターについての備忘録的メモです。不正確な部分も多々あるかと思うので詳しくは論文を参照してください。

Action Recognition

ActivityNet workshop

今回の参加目的の一つはこのワークショップに参加することでした。

人の入りはまあまあ。写真は部屋の前半分です。全体で40人くらいでしょうか。遠くで演台に立っているのがオーガナイザの一人 Bernard Ghanem氏(King Abdullah University of Science and Technologyの准教授)です。

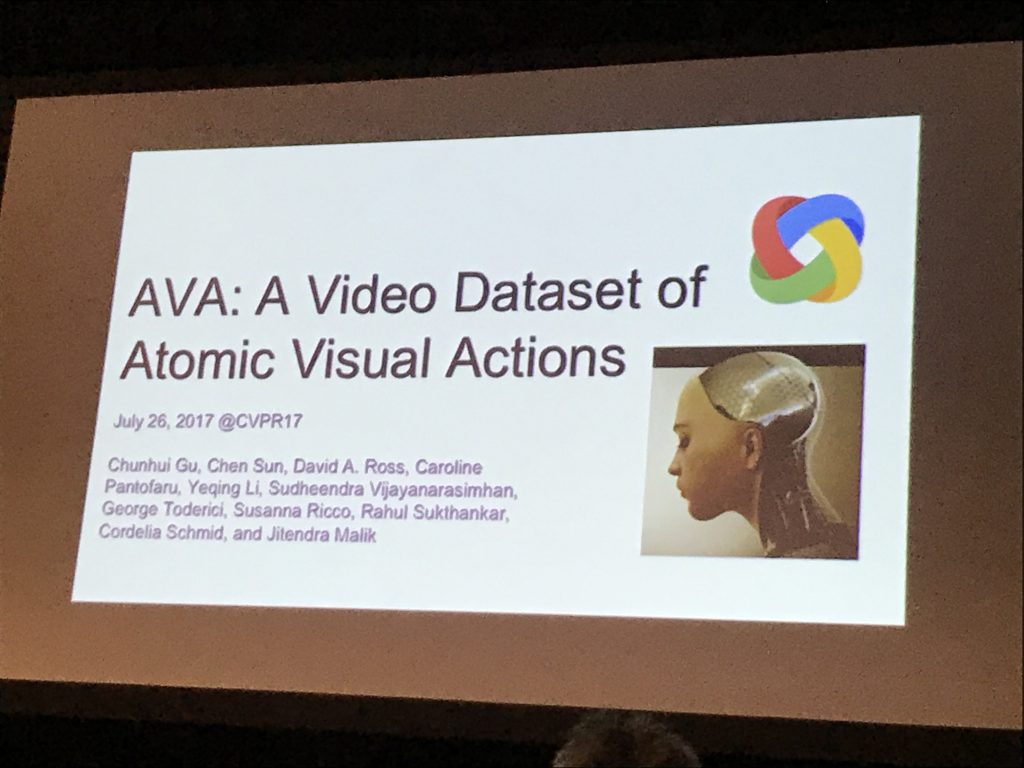

ワークショップは招待講演二つとコンペの結果発表という二部構成。招待講演はDeepMindのJoao CarreiraによるKineticsの話とGoogle/BerkeleyのJitendra MalikによるAVAの話。

先に書きましたがAVAの話は面白かったです。

コンペティションは以下の5つの部門からなります。カッコ内は対象データセットです。

結果はリーダーボードにあります。

ProposalやLocalizationの精度はまだ改善の余地がたくさんありそうです。

以下はオーラル発表やポスターを見て気になったもののリストです。

Action Recognition Posters

Action Recognitionのいくつかのポスターを紹介します。

Zero Shot (ハナノナ向けにも)

[action recognition]

– Zero shot action recognition with Error-Correcting Output Codes

[image]

– Semantically Consistent regularization for zero shot recognition

– Fine-grained recognition of thousands of object categories with single-example training

– Semantic auto encoder for zero-shot learning

– Zero shot learning via multi-scale manifold regularization

VQA

– Toward Spatio-Temporal Reasoning in Visual Question Answering

– Counting everyday objects in everyday scenes

– Multi-level attention networks for visual question answering

Action Detection and Segmentation

– Temporal Convoutional Networks for Action Segmentation and Detection

– SCC: Semantic context cascade for efficient action detection

Caption

– Unsupervised visual-linguistic reference resolution in instructional videos

tutorial videoから手順をテキストスクリプト化する

Li Fei Feiが共著者

– Video captioning with transferred semantic attributes

[image]

– The more you know: Using knowledge graphs for image classification

– Deep variation-structured reinforcement learning for visual relationship and attribute detection

Classification

[2d image]

– Densely connected Convolutional Neural Networks (Best Paper AWARDS)

DenseNet, Githubにtorch版のコードあり → ハナノナ

– Look closer to see better: recurrent attention convolutional neural networks for fine-grained image recognition

MSR Asia, Microsoft Flower

[3d data]

– PointNet: Deep learning of point sets for 3d classification and segmentation

– Learning and refining of privileged information-based RNNs for action recognition from depth sequences

SLAM

– Semi-suerpervised deep learning for monocular depth map prediction

– ScanNet: Richly-annotated 3D reconstructions of Indoor scenes

Theory

– Global Optimality in neural network training

Dataset creation

– Learning from synthetic humans

motion captureされた動作をCGにインポートして動作動画のデータを大量に合成