【開催報告】第27回ステアラボ人工知能セミナー 高瀬翔 先生「少量の計算資源でも利用可能な自然言語処理モデルを目指して」 Seminar Report: The 27th STAIR Lab AI Seminar: Dr. Sho Takase, "Toward a Natural Language Processing Model Feasible with Limited Computational Resources"

2021.05.29

2021.05.29

2021年5月28日(金)に第27回ステアラボ人工知能セミナーをオンラインで開催しました。

今回は東京工業大学の高瀬 翔先生をお招きして、「少量の計算資源でも利用可能な自然言語処理モデルを目指して」という題目でご講演いただきました。

講演ではまず自然言語処理とは何かの概説から始まり、近年広く用いられているニューラルネットワークを用いた言語モデルとその問題点の一つ、すなわち、手法の改良にともなってモデルのパラメタ数が増大してしまい、その増加のペースは1年に1000倍以上にもなっていることについてご説明頂きました。

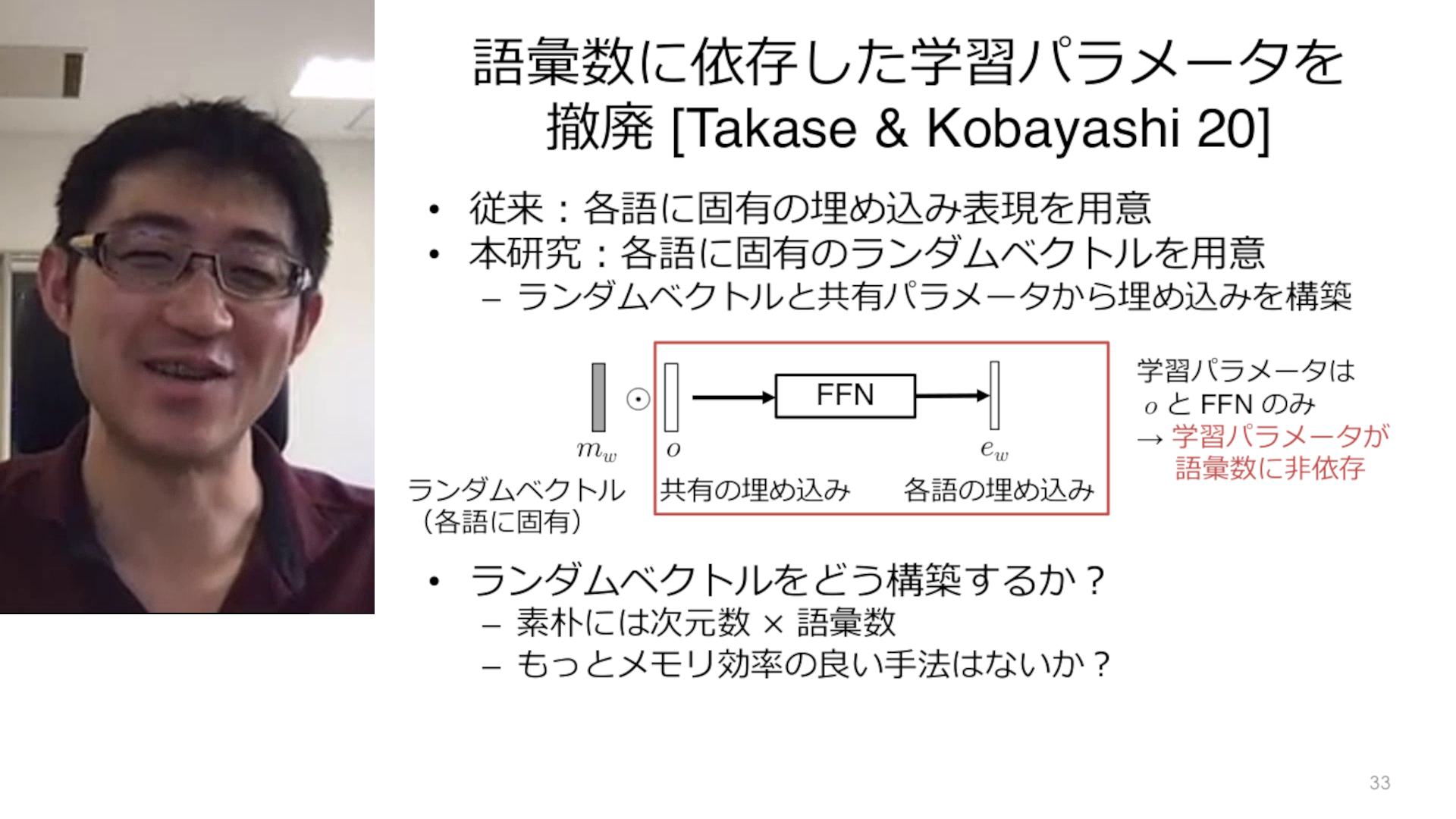

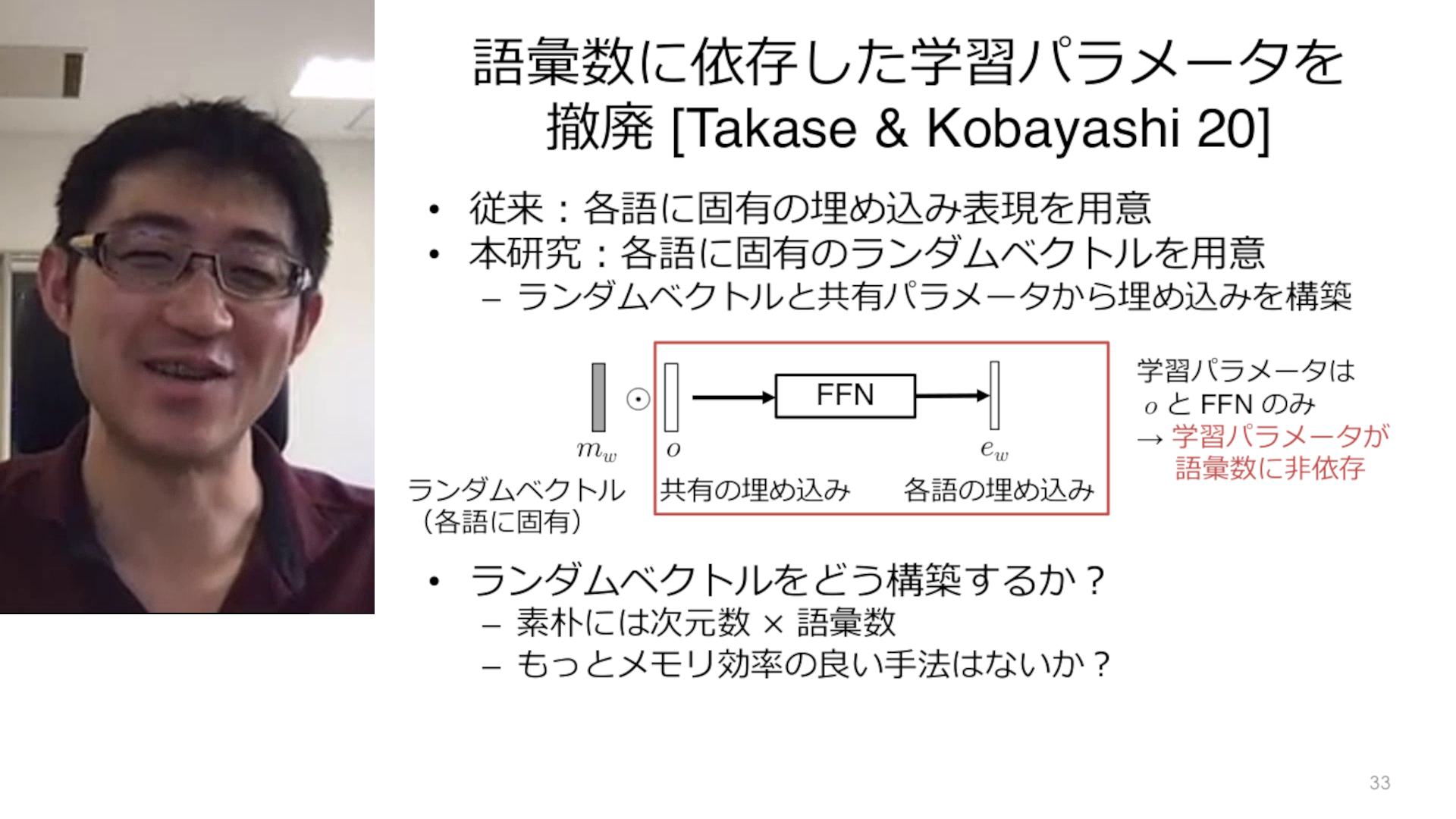

次いで、このパラメタ数の増大の問題へ対処するための近年の研究動向についてご紹介頂きました。具体的には、まず学習済みのモデルのパラメタ数を削減する手法として、蒸留 (モデルの出力をより小規模なモデルで再現しようとする手法) と圧縮 (モデル内の不要なパラメタを削除しようとする手法) についてご説明頂きました。次に、よりパラメタ数の少ないモデルでゼロから学習する手法として、埋め込み表現の軽量化や中間層でのパラメタ共有によるパラメタ数削減について、高瀬先生の最新の研究成果を交えてご説明頂きました。

We held the 27th STAIR Lab AI Seminar on May. 28, 2021.

Dr. Sho Takase, School of Computing, Tokyo Institute of Technology, gave a talk titled “Toward a Natural Language Processing Model Feasible with Limited Computational Resources”.

以下は講演スライドです。ぜひご覧ください!

The following is the talk slides (in Japanese). Please do have a look!

以下は講演動画です。ぜひご覧ください!

The following is the talk video (in Japanese). Please do have a look!