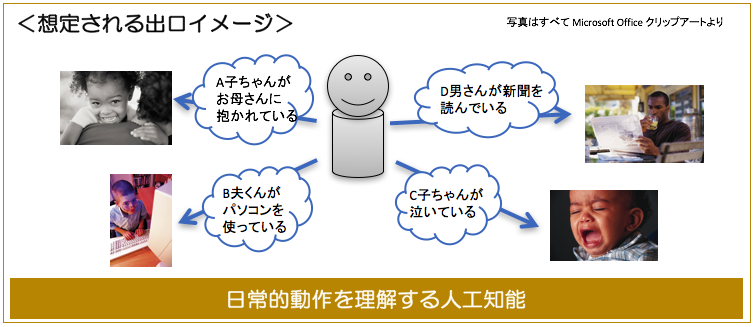

このプロジェクトは、人間の日常的な動作をきめ細かく認識・理解する人工知能の開発に取り組んでいます。

家庭に置かれたロボットが家族の一人一人が家のどこで何をしているかを観察して記録し、「お母さんはどこ?」と聞くと「キッチンで料理しています」と答えることができるようなそういう人工知能をイメージしています。

このプロジェクトは2016年度より国立研究開発法人新エネルギー・産業技術総合開発機構(NEDO)の支援を受け、産業技術総合研究所AI研究センターと協力して実施しています。2019年度までの大まかな研究ロードマップは、(1) 動画を見て動作を認識する基本的な認識エンジンの研究開発、(2) 動画を見てその内容説明するテキストを生成するエンジンの研究開発、(3) 動画を見てその内容に関する質問応答を行うシステムの研究開発、という流れです。

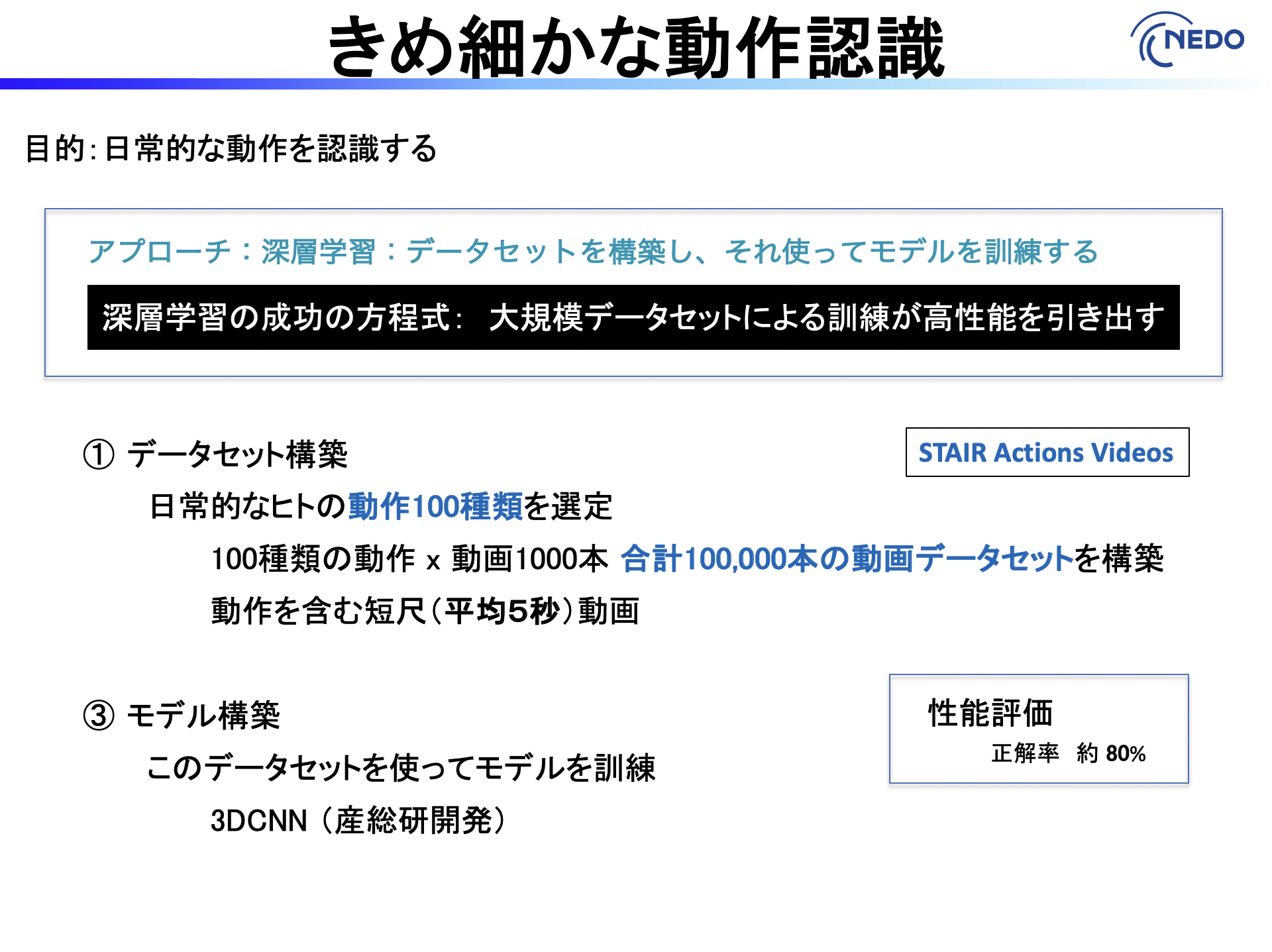

2016年度は深層学習に基づく動作認識エンジンの開発とそのエンジンの訓練用のデータセット “STAIR Actions Videos” の開発を行いました。データセットは日常的な100種類の動作それぞれについて1000本の動画からなる合計100,000本の動画データセットです。

STAIR Actions Videosは公開しています。詳しい情報は末尾の案内を御覧ください。

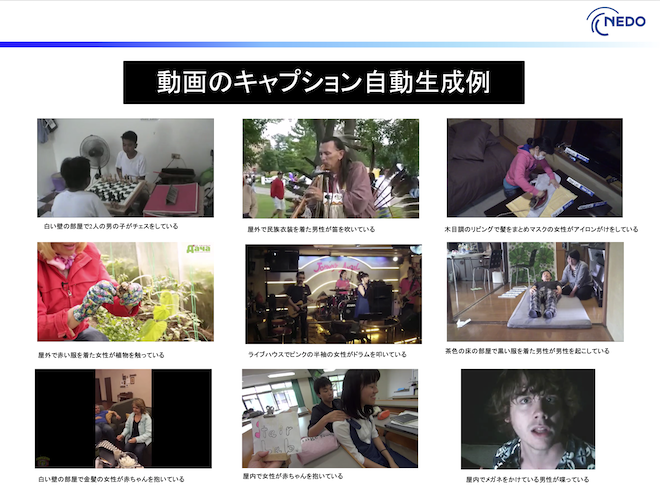

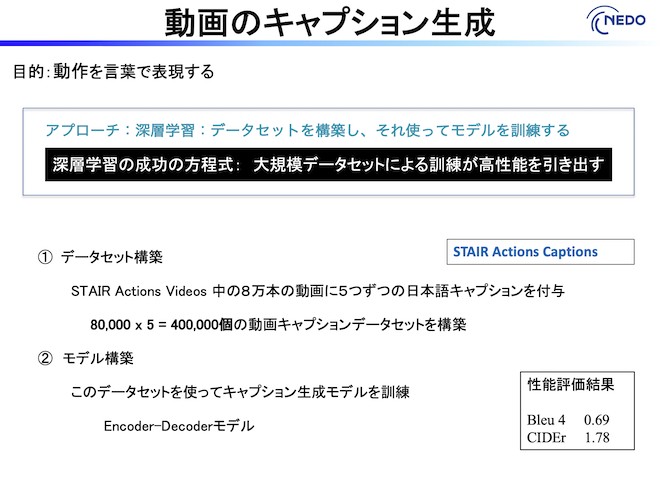

2017年度は動画のキャプション生成エンジンの開発とそのエンジンの訓練用のデータセット “STAIR Actions Captions” の開発を行いました。データセットは 80,000万個の動画にそれぞれ5つの日本語キャプションを付けたものからなり合計400,000キャプションです。これは日本語では初、英語も含めて世界最大の動画キャプションデータセットです。

このエンジンで生成されたキャプション例を以下に示します。(動画は都合によりサムネイルだけを表示しています)

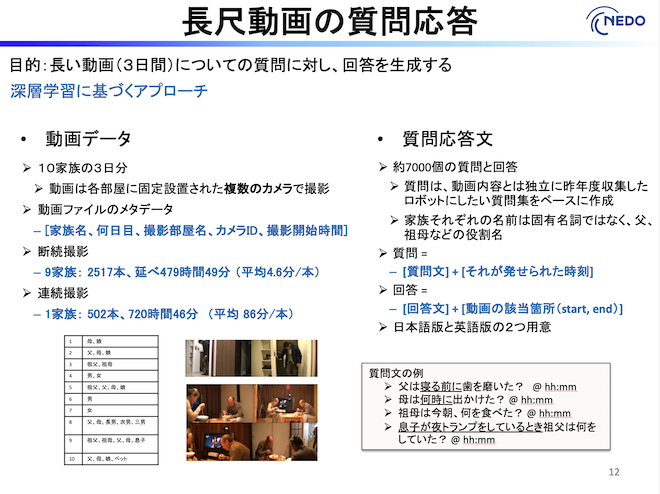

2018-2019年度は動画を見てその内容に関する質問応答を行うシステムの研究開発を行いました。STAIR Actions Videosに含まれるような短い動画の質問応答であればだいたい7割程度の正解率が達成できています。難しいのはもっと長い動画についての質問応答です。この研究のために10個の家族の3日間の生活記録動画データセットを構築しました。これを使って、三日間の出来事であればいろんな質問に答えられるAIを研究開発しています。動画データセットの概要をいかに示します。

皆様の研究に役立てていただければ幸いです。